IA et SMQ - Mémo Table ronde Santexpo - Mai 2024 - Organisé par Lifen

Ce mémo a servi comme base de réflexion à Mme Florence Jubault Responsable Qualité & Gestion des risques (Clinique Mutualiste La Sagesse MCO), en préparation de cette table ronde. (Ce mémo ne reflète en rien les discussions et échanges qui se sont déroulés par la suite lors de la table ronde)

Maël Floc'h - MedImAgile S.A.S.

9/25/202411 min read

Généralités

Une blague relativement commune « d’informaticien », dit que les problèmes sont très majoritairement issus de l’élément situé entre la chaise et le clavier (1): ICC (Interface Chaise Clavier)

De ce trait d’humour de « Geek », il faut cependant retenir une des bases de l’informatique : un ordinateur exécute ce qu’on lui demande de faire.

Dans ce sens, une I.A. opère exactement de la même façon. C’est-à-dire qu’elle va rendre en sortie (résultats, calculs, texte, image…) des éléments traités pour un problème spécifique, sur des entrées qui lui ont été fournies pour ce problème spécifique.

En d’autres termes, une I.A. fournira des résultats précis et concordants, si la question posée entre dans un cadre unique, bien défini et standardisé, en regard de ce qui aura servi de base d’entraînement.

On ne peut pas utiliser un tournevis pour enfoncer un clou, et espérer obtenir un résultat correct.

Glossaire

A.I./AI: Artificial Intelligence

FORTRAN: FORmula TRANslating system

LISP: LISt Processing

COBOL: COmmon Business-Oriented Language

ENIAC: Electronic Numerical Integrator And Computer

EDVAC: Electronic Discrete Variable Automatic Computer

PC: Personal Computer

DL: Deep Learning

ML: Machine Learning

CPU: Computer Process Unit

GPU: Graphic Process Unit

DVP: Développement (Analyse, Conception, Test, Déploiement)

DM: Dispositif Médical

MDR: Medical Device Regulation

SMQ: Système de Management de la Qualité

DSI: Département/Direction des Systèmes Informatiques

Histoire

Tout d’abord, la réflexion autour de l’I.A. date des années 50. Plus précisément, dès 1949 John McCarthy, étudiant en mathématiques à la Caltech, cherche à développer un langage capable de traduire les raisonnements propres à l’humain au sein de programmes informatiques. Puis, en 1955, lors d’un atelier d’été où étaient rassemblés de grands spécialistes du calcul assisté, il propose le terme « Intelligence Artificielle » (2).

Ainsi, le terme et concept AI, existe depuis plus de 70 ans !

Pour mémoire, les langages de l’époque, FORTRAN, LISP (inventé par John McCarthy et toujours utilisé) ou encore COBOL, demandent beaucoup de page d’écritures, sont du domaine de spécialistes et totalement inconnus du grand public.

NB : Pour rappel, le premier langage informatique a été inventé par une femme en 1842, Ada Lovelace, portant son nom : ADA (https://www.cigref.fr/archives/histoire-cigref/blog/langage-informatique-savoir-coder-une-longue-histoire/)

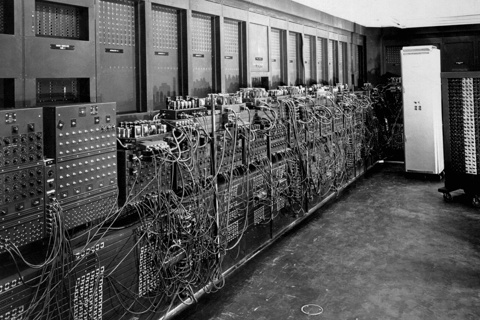

Concernant le matériel, les ordinateurs de l’époque occupent des salles entières (160 m² pour l’ENIAC en 1943), possèdent peu de mémoire et très peu de performance de temps de calculs.

1943 : ENIAC

Aucune pièce mécanique

18000 lampes

160 m²

1946 : EDVAC

Mémorisation

1948 : Apparition du transistor

1970 : Systèmes d’exploitation

1971 : Microprocesseur

1981 : PC

Depuis les années 90 :

Arrivée d’internet qui va accélérer la communication et les échanges

Arrivée des nanotechnologies qui vont permettre la miniaturisation et les smartphones

Arrivée de la 4G qui va encore diminuer les temps de transferts des données

La robotisation et l’impression 3D

Traitement de grandes bases de données (Big Data)

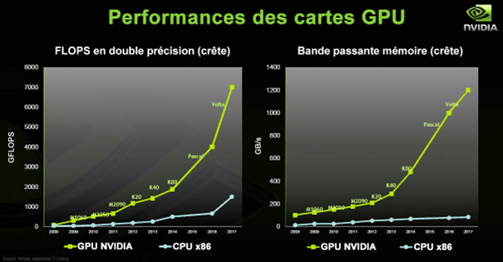

Mais le plus important l’évolution rapide des GPU qui va permettre l’accélération du DL, et donc la consolidation de l’I.A.

ENIAC (1943) - Source : https://www.simslifecycle.com/blog/2022/the-journey-of-eniac-the-worlds-first-computer/

Après ce rapide historique, il est plus facile de décrypter cette émergence frénétique de l’I.A. et ses applications dans notre quotidien lors de ces cinq dernières années.

A noter que l’évolution des composants électroniques connaît plusieurs crises depuis 2021, et tout particulièrement la production les semi-conducteurs, qui intervient directement sur les performances des ordinateurs actuels (CPU et GPU).

Fonctionnement

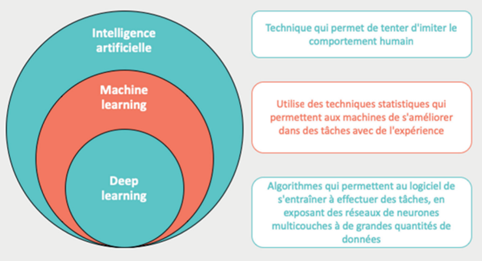

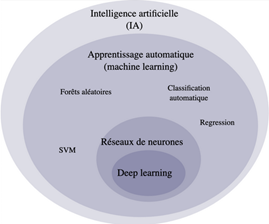

Source : Laurent Brocker, Claire Fazilleau, David Naudin. L’intelligence artificielle en médecine : intérêts et limites. Oxymag, 2019, 32, pp.8 - 13. ff10.1016/j.oxy.2019.06.003ff. ffhal-03487963fi ...

Le DL fait partie du ML, faisant lui-même partie de l’ensemble Intelligence Artificielle.

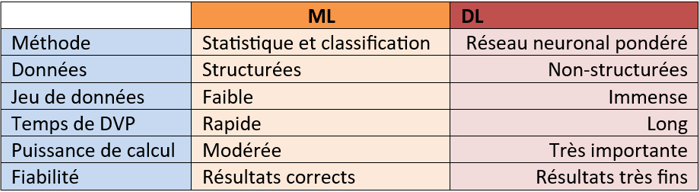

La différence entre ML et DL demeure difficile et subtile à définir. Il est donc préférable pour une compréhension simple et généraliste de s’attacher à l’aspect fonctionnel de développement.

Ainsi, le ML est basé sur des outils de statistique et de classification. Alors que le DL est basé sur des couches de réseaux neuronaux et de pondérations. Le ML nécessite peu de données structurées d’entraînement, quand le DL demande beaucoup de données non structurées, c’est pour cela que l’on parle de Big Data, autre différence majeure (de l’ordre d’un facteur 1000 au minimum). Enfin, si un algorithme d’entrainement en ML requiert quelques jours d’entraînement, il faudra plusieurs semaines pour un réseau de neurones en DL.

Un des défis de l’I.A. est de pouvoir égaler les capacités de simulation et d’émulation du cerveau. L’I.A. est supérieure à l’homme sur des tâches très précises (comme la reconnaissance de tumeurs). Cependant, le cerveau humain est encore bien supérieur à l’I.A. dans bien des domaines. D’une part, le cerveau humain a intégré, quasiment dès la naissance, une certaine conception du monde en général que l’IA, dans l’état actuel de son développement, ne pourra atteindre. En effet, cet apprentissage nécessiterait trop de données et trop de temps. En outre, le cerveau humain n’a pas besoin d’être exposé à des millions d’exercices pour généraliser un concept ou une règle, là où l’IA a besoin de big data.

Extrait de : L’intelligence artificielle en médecine : intérêts et limites. Laurent Brocker, Claire Fazilleau, David Naudin.

Définition

John McCarthy en 1955 définissait l’I.A. selon ces termes : « C’est la science et l’ingénierie de créer des machines intelligentes ». L’une des applications premières fût de créer un jeu d’échec (Kotok-McCarthy).

70 ans plus tard, il est intéressant de voir qu’il existe plusieurs façons de définir l’I.A. dont voici une parmi tant d’autres :

Le terme « Intelligence Artificielle » désigne l’utilisation de systèmes informatiques pour résoudre des problèmes spécifiques d’une manière qui simule le raisonnement humain. Les logiciels d’I.A. se présentent sous la forme d’algorithmes informatiques, qui sont des morceaux de code informatique représentant des instructions à suivre afin de résoudre un problème spécifique. Dans sa forme la plus fondamentale, l’algorithme prend des données en entrée, effectue un calcul sur ces données et renvoie des données en sortie (3).

A ce stade, il est très important de prendre un moment de réflexion sur ces deux définitions, temporellement différentes, mais se rejoignant sur le fond.

M. McCarthy souhaitait en fait utiliser un langage dans un but précis et à des fins espérées. Le mot ordinateur n’existe pas en 1955. Ainsi, il souhaitait utiliser un « système informatique » dans le cadre d’un « problème spécifique » (Jeux d’échec) en « simulant le raisonnement humain ».

Marketing et Application de l’I.A.

Le terme d’I.A. est présenté au grand public selon plusieurs sources avec l’arrivée de ChatGPT en décembre 2022. D’autres références, évoquent l’arrivée de l’I.A. au grand public autour de 2010 avec les assistants personnels intelligents (ou assistants personnels virtuels) comme Google Home par exemple.

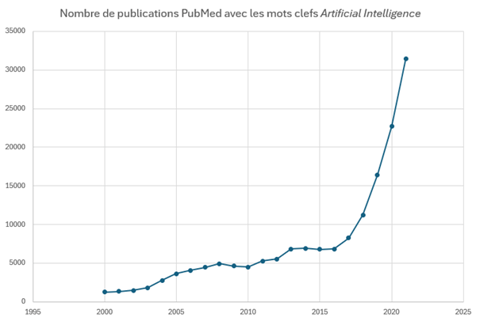

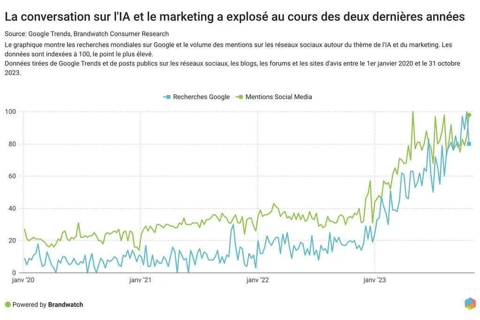

Dans tous les cas, le terme I.A. a littéralement explosé dans les publications médicales aux alentours de 2016. Puis, le marketing s’en est saisi depuis 2023 avec un martelage déraisonné, parfois mensonger, et le plus souvent décorrélé de son sens premier :

« Utilisation de systèmes informatiques pour résoudre des problèmes spécifiques d’une manière qui simule le raisonnement humain ».

Le recours au terme I.A. est devenu incontournable dans tous les messages publicitaires, que ce soit pour le grand public, ou bien les OEM et les fournisseurs de logiciels dédiés au monde médical. Les deux graphiques suivants soulignent cette envolée :

De 2016 à 2018 au RSNA à Chicago, sont présentées à la communauté radiologique les premières études réalisées en utilisant des algorithmes basés sur de l’I.A. (ML ou DL).

« Prometteur » est le terme qui revient le plus souvent, ainsi que « remplacement ». Un vent de panique émerge en effet sur la possibilité de voir disparaître certains métiers ou acteurs de la santé. Néanmoins et très rapidement, la communauté radiologique et en première ligne, américaine, devine le potentiel d’aide et de support auxquels l’I.A. pourrait contribuer.

L’Europe avec un léger décalage comprend également tout l‘intérêt d’intégrer ces solutions d’I.A. dans le parcours patient, d’autant plus après l’alerte lancée par l’OMS en septembre 2022, sur la pénurie à venir des acteurs de la santé, qui touchera également l’Asie (4).

Le 18 avril 2018 est une date clé car la FDA délivre le premier 510k, sésame de droit d’entrée sur le marché américain pour un DM, à un logiciel d’I.A. autonome, dans le cadre de la pathologie rétinienne diabétique : IDx-DR (5).

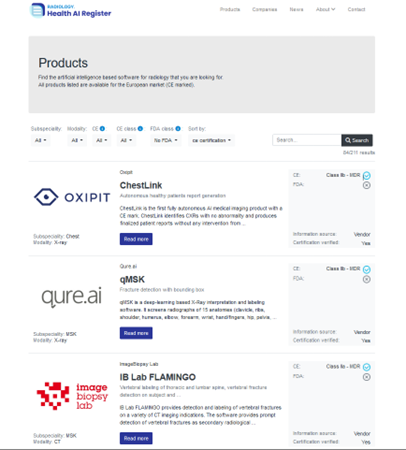

Depuis cette date, ce sont près de 900 logiciels d’I.A., dont 211 concernant la radiologie, qui ont été approuvés par la FDA. Un site internet fréquemment mis à jour est d’ailleurs dédié au recensement de ces logiciels approuvés utilisé en radiologie (6).

On y trouve également leur référencement CE/MDR approuvé : https://radiology.healthairegister.com/

Régulation et juridique

Nous venons de le voir les instances de régulations se sont emparées du sujet I.A. Elles sont constamment sollicitées tant au niveau approbations, que conseils et orientations. Ainsi, afin de cadrer au plus tôt l’évolution et l’utilisation de de l’I.A., chaque continent/pays travaille avec les associations nationales médicales, les juristes et même les patients comme cela a été le cas lors d’une réflexion sur l’engagement patient rapportée dans le journal AMA Journal of Ethics :

« …le dialogue sur ces préoccupations permettra aux médecins et aux patients de mieux comprendre le rôle que l’IA peut jouer dans les soins de santé, aidant ainsi les intervenants à avoir une idée réaliste de ce que l’IA peut et ne peut pas faire… » (7).

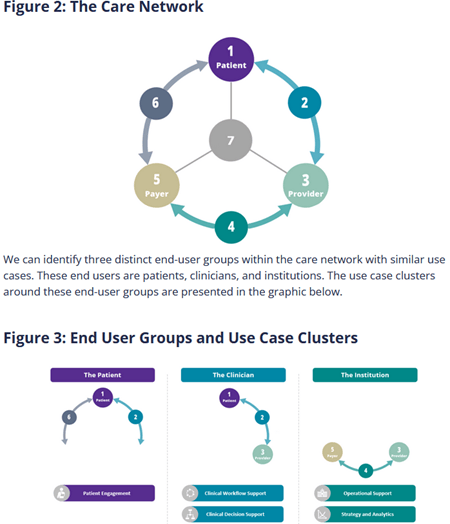

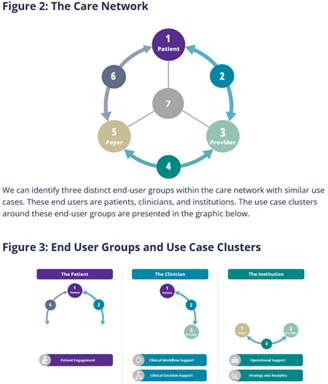

Dans ce sens, la compagnie Signify Research qui s’intéresse aux tendances à venir propose un process pertinent sur l’engagement du patient dans le développement de l’I.A. dans le parcours de soin :

Beaucoup ont déjà anticipé et réfléchi sur le cadrage du périmètre de l’I.A. et plus particulièrement concernant les Systèmes de Management de la Qualité et/ou la gestion des risques. Plusieurs articles existent déjà et comme le DL apprend (Affinage) de ses erreurs, les échanges et discussions sont constamment mises à jour en proposant des guides, des recommandations, des grilles d’évaluation, en proposant des outils de plus en plus pertinents. On peut ainsi citer arbitrairement :

HAS : Grille descriptive des fonctionnalités des dispositifs médicaux embarquant un système avec apprentissage automatique (intelligence artificielle)

Le conseil d’Europe : L’impact de l’intelligence artificielle sur les relations médecin-patient

OCDE : IA en sante : Immense potentiel énormes risques

En regard du fonctionnement d’un ordinateur et de l’I.A., il est beaucoup plus aisé de les appliquer à des standards, des procédures établies et cadrées, des bibliothèques de données étiquetées. Or c’est l’essence même du contrôle qualité.

Il faut donc bien considérer l’I.A. comme un outil opportun sur lequel s’appuyer pour les SMQ.

La liste est non exhaustive mais on peut déjà penser à des applications directes dans :

La traçabilité, l’étiquetage, la gestion des stocks (Péremption)

La récurrence des pannes et leur anticipation

Le taux de fatigue des équipes en regard des heures travaillées

L’isolation d’invariants au sein de données multiparamétriques dans un contexte de SMQ

Les alertes d’actions hors périmètre en temps réel

Les procédures basiques de contrôle qualité automatisé (Diagramme d'Ishikawa ou causes/effets, les 5 « Pourquoi ? », Diagramme de Pareto…)

Ressources

Au-delà des équipes déjà en place liées au SMQ, il faudra néanmoins les consolider avec d’autres spécialistes ou à minima prévoir des formations et montée en compétences du personnel en place. Outre la DSI impliquée dans la gestion des risques informatiques, la cybersécurité notamment, il sera envisageable d’avoir par exemple un développeur maîtrisant le codage en Python et Java, étant donné que ces 2 langages sont majoritairement utilisés en I.A. La connaissance en C++ et Julia sera un atout supplémentaire. Le DVP en interne, la maintenance et les échanges avec les fournisseurs d’I.A. seront facilités par l’intégration de tels spécialistes au sein des DSI. Ils permettront entres autres de traiter les biais et les erreurs de dérives propres à l’I.A. en contrôlant les données d’entrée, ou encore en assurant le respect du cadre d'utilisation de l'I.A.

De même, si certaines lacunes juridiques sont apparues sur le sujet avant 2022, ces vides commencent à se combler. Mais on peut alors aussi envisager un juriste ou bien un consultant juridique spécialisé en I.A., afin d'anticiper et réfléchir sur les questions de responsabilités.

Discussion

Bien que l’I.A. ait sommeillé durant 70 années, la dernière décade a connu une croissance exponentielle, en grande partie liée aux échanges qu’a permis internet et les progrès technologiques des composants électroniques. Le marketing et de facto les marchés émergeants ont propulsé l’I.A. dans le domaine de la santé.

Ainsi, et comme tout fait sociétal il faut désormais accompagner, s’approprier et encadrer cette évolution.

C’est une étape cruciale qu’il ne faut pas craindre, d’autant plus que les SMQ respectent des standards et des procédures aujourd’hui bien établis et documentés.

Il reste à définir et délimiter encore quelques rôles en amont et affiner d’autres rôles en aval. Mais dans tous les cas, l’I.A. semble apparaître comme un outil relativement bien calibré pour le contrôle qualité.

Le développement de l'I.A. va nécessiter un besoin en ressources naturelles croissant, en lien avec les attentes de performances. Or la fabrication des semi-conducteurs connaît déjà des crises d'approvisionnement. (https://siecledigital.fr/2024/05/13/de-taiwan-aux-etats-unis-lindustrie-des-semi-conducteurs-face-a-la-secheresse/)

Dernières remarques à ne pas oublier, aujourd’hui environ 70% de la population mondiale n’a pas d’accès aux soins. Ce qui fait autant de milliards de données, de variantes et d’exceptions que l’I.A. ne connaît pas.

Comment apprendre quelque chose qu’on ne connaît pas, à un algorithme ?

Encore une fois, que ce soit en ML ou en DL, les résultats obtenus sont propres à une demande spécifique. Les différences anatomiques et physiologiques entre chaque être humain sont relativement importantes pour pouvoir être standardisées.

En revanche, les tests de qualité sont et peuvent être harmonisés encore plus profondément avec l’outil I.A.

Chihuahua ou muffin ? (d’après Karen Zack on Twitter©)

Références

2- https://www.cigref.fr/archives/histoire-cigref/blog/pere-d-intelligence-artificielle-john-mccarthy/

3- The Complete Guide to Artificial Intelligence in Radiology - Calantic™ Digital Solutions - © 2022 Bayer

5- https://www.jonesday.com/en/insights/2018/05/fda-permits-marketing-of-first-autonomous-artifici